El dilema del algoritmo: ¿Cómo garantizar la equidad, la transparencia y la rendición de cuentas cuando la IA toma las decisiones financieras?

La integración de la Inteligencia Artificial en el sector financiero ha dejado de ser una promesa futurista para convertirse en una realidad omnipresente. Desde la detección de fraudes y el trading algorítmico de alta frecuencia hasta los robo-advisors que gestionan carteras de inversión y los modelos de scoring crediticio, la IA es el motor invisible que impulsa la banca y las finanzas modernas. Su capacidad para procesar volúmenes masivos de datos a velocidades inalcanzables para el humano ha generado inmensos beneficios en eficiencia y personalización. Sin embargo, este poder computacional conlleva un profundo dilema ético: ¿Cómo garantizar que estas máquinas tomen decisiones de manera justa, transparente y responsable?

Para inversores, usuarios y reguladores, la respuesta reside en la adopción de un marco de Inteligencia Artificial Responsable (IAR). Este enfoque no busca frenar la innovación, sino asegurar que el despliegue de la IA se realice en estricta alineación con los valores sociales, los derechos fundamentales y los principios de estabilidad financiera. En un sector donde la confianza es el activo más valioso, la IAR se convierte en el nuevo estándar de oro para la gobernanza algorítmica.

I. Los Tres Pilares Éticos del Riesgo Algorítmico

El riesgo que introduce la IA en el sector financiero es cualitativamente diferente al riesgo operacional o de mercado tradicional. Se centra en el diseño, la opacidad y las consecuencias sistémicas del algoritmo.

1. Sesgo y Discriminación Algorítmica (La Equidad)

El desafío ético más comentado es el sesgo. Los sistemas de IA aprenden de los datos históricos. Si estos datos reflejan patrones de discriminación histórica —por ejemplo, en la concesión de créditos a minorías o en la fijación de primas de seguros basadas en códigos postales—, la IA no solo replicará, sino que a menudo amplificará estos sesgos, haciéndolos sistémicos y difíciles de rastrear.

- El Efecto Bucle de Retroalimentación: Si un modelo crediticio discrimina a un grupo, este grupo tendrá menos historial crediticio positivo en el futuro, lo que «enseña» al modelo a seguir discriminando. La IA no es neutral, es un espejo de la sociedad, y en finanzas, un espejo con poder de decisión.

- Mitigación: La IAR exige la auditoría de sesgos (Fairness Audits). Esto incluye la inspección de los datos de entrenamiento para identificar variables proxy (como el nombre o la ubicación) que podrían estar sesgando los resultados, y la aplicación de métricas de equidad, asegurando tasas de aprobación y denegación similares entre diferentes grupos demográficos.

2. Opacidad y el Problema de la «Caja Negra» (La Transparencia)

Muchos modelos avanzados de IA, como las redes neuronales profundas (Deep Learning), son inherentemente complejos y difíciles de interpretar, creando lo que se conoce como la «caja negra» algorítmica. Un robo-advisor puede recomendar una inversión, o un algoritmo puede denegar un préstamo, sin que el desarrollador, el regulador, o el propio usuario puedan explicar el porqué exacto de esa decisión.

- El Derecho a Explicación: En finanzas, la opacidad viola el derecho fundamental de los usuarios a entender la base de una decisión que afecta su bienestar económico. Para los inversores, esto complica la diligencia debida y la evaluación de riesgos.

- Explicabilidad (XAI): La IAR promueve la IA Explicable (XAI), donde el foco no está solo en la precisión predictiva del modelo, sino en su capacidad para generar justificaciones comprensibles. Herramientas como LIME y SHAP buscan arrojar luz sobre las variables que tuvieron mayor peso en el resultado final, permitiendo la rendición de cuentas.

3. Responsabilidad y Rendición de Cuentas (La Gobernanza)

Cuando una IA comete un error costoso, ya sea una pérdida millonaria en el trading algorítmico o una denegación crediticia errónea que perjudica a un individuo, ¿quién es responsable legalmente? ¿El desarrollador que codificó el algoritmo, la entidad financiera que lo implementó, o el modelo mismo?

- Marcos de Responsabilidad: La normativa emergente, como la Ley de IA de la Unión Europea, tiende a colocar la responsabilidad última en la entidad financiera que implementa el sistema. Esto obliga a las instituciones a establecer rigurosos marcos de gobernanza y supervisión humana.

- Supervisión Humana (Human-in-the-Loop): Los sistemas críticos de IA, especialmente aquellos con potencial de daño sistémico, no deben operar de forma totalmente autónoma. La IAR exige puntos de control y revisión humana (Human-in-the-Loop) para intervenir en decisiones de alto riesgo y auditar el rendimiento del modelo en tiempo real.

II. Guía para Inversores: Diligencia Debida Algorítmica

Para el inversor que considera dónde asignar su capital en la era de la IA, la responsabilidad no es solo un asunto ético, sino también un factor de riesgo financiero y reputacional. Las empresas con mala gobernanza de IA están expuestas a multas regulatorias, litigios y pérdida de confianza.

1. Auditando el Riesgo Reputacional y Regulatorio

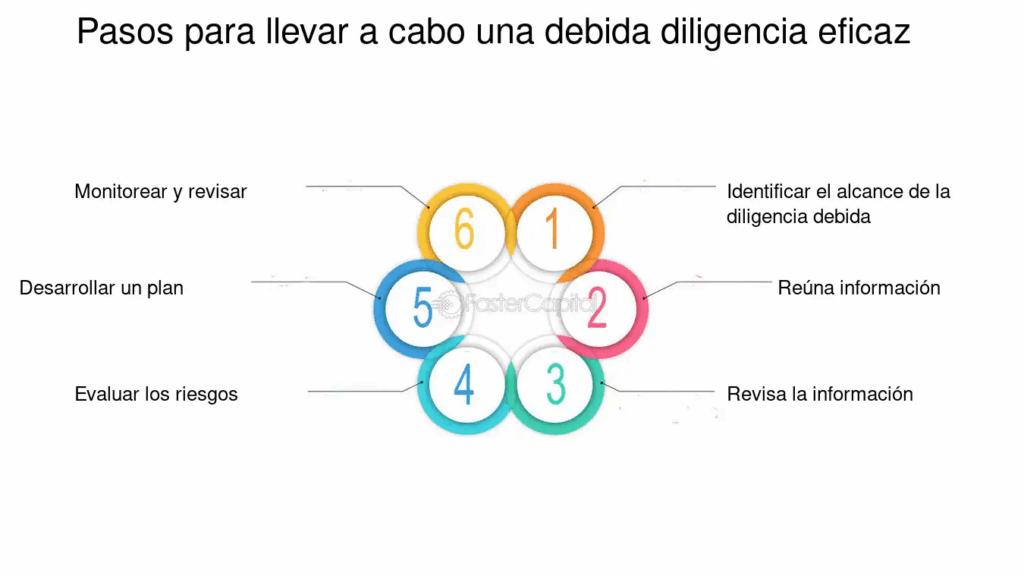

Antes de invertir en una Fintech o una institución financiera que se jacte de su uso de IA, haga las siguientes preguntas de diligencia debida:

- ¿Existe un Comité de Ética de IA? Una estructura formal que supervise la implementación de la IA indica un compromiso serio con la IAR.

- ¿Cuál es el «Modelo de Transparencia» de la empresa? ¿La empresa publica cómo se utilizan sus modelos? ¿Existe un canal para que los usuarios impugnen decisiones automatizadas?

- ¿Cómo se gestionan los datasets de entrenamiento? Las empresas deben demostrar que han auditado y corregido los sesgos en los datos históricos utilizados.

2. Inversión en la Cadena de Suministro de la IAR

La necesidad de IAR está creando nuevas oportunidades de inversión en empresas que resuelven los problemas éticos de la IA:

- XAI y Servicios de Auditoría Algorítmica: Empresas que desarrollan software para hacer los modelos de IA más interpretables (XAI) o firmas de consultoría que se especializan en la auditoría de sesgos.

- Ciberseguridad y Protección de Datos: Invertir en software y servicios que protegen los datasets de entrenamiento y los modelos de IA contra ataques de data poisoning o manipulación, que son riesgos críticos en el sector financiero.

- Infraestructura Regulada: Priorizar a las empresas que operan en jurisdicciones con marcos regulatorios de IA claros, ya que la predictibilidad legal reduce el riesgo de multas o suspensiones operativas inesperadas.

III. Guía para Usuarios: Cómo Reclamar tus Derechos Algorítmicos

El usuario de servicios financieros automatizados debe ser proactivo en la defensa de sus «Derechos Algorítmicos».

1. Entiende el Perfilado y el Scoring

Prácticamente todas las decisiones financieras modernas están influenciadas por tu perfil algorítmico: tu riesgo crediticio, tu propensión al fraude, e incluso tu perfil de inversor.

- Pregunta Específicamente: Si te deniegan un préstamo, una tarjeta o una hipoteca, pregunta: «¿Se tomó esta decisión utilizando un sistema automatizado? Si es así, ¿cuáles fueron las principales variables que contribuyeron negativamente a la decisión?». En muchas jurisdicciones, el Reglamento General de Protección de Datos (GDPR) de la UE otorga el derecho a no ser objeto de decisiones basadas únicamente en el procesamiento automatizado.

- Busca la Revisión Humana: Si sientes que la decisión fue injusta o sesgada, solicita una revisión manual por parte de un agente humano. La supervisión humana es una capa de defensa crítica contra el error algorítmico.

2. Cuestiona la Opacidad

Las condiciones de servicio a menudo son vagas sobre el uso de la IA. Como usuario, debes exigir claridad.

- Exige Información Simple: Las instituciones financieras tienen el deber de comunicar el uso de la IA en un lenguaje simple y accesible, no en jerga técnica. Si la explicación es incomprensible, es probable que la empresa esté eludiendo la transparencia.

Conclusión: La IAR como Imperativo de Confianza

La Inteligencia Artificial tiene el potencial de democratizar el acceso al crédito, hacer la inversión más eficiente y eliminar los prejuicios humanos inconsistentes. Sin embargo, este potencial solo se realizará si la industria y los reguladores priorizan la Inteligencia Artificial Responsable.

La IAR no es un obstáculo, sino un catalizador para la confianza. Al abordar activamente el sesgo, la opacidad y la responsabilidad, las instituciones financieras aseguran su viabilidad a largo plazo. Para el inversor y el usuario, el conocimiento de los principios de la IAR es la mejor herramienta para evaluar el riesgo, exigir la equidad y, en última instancia, navegar con éxito por la próxima era de las finanzas. La responsabilidad algorítmica es el puente entre la velocidad de la máquina y la ética del ser humano.